春节期间,Deepseek 凭借其卓越的性能表现吸引了大量用户的关注。虽然一些用户认为它并不特别突出,但许多国际巨头对其性能感到震惊,这足以证明 Deepseek 的非凡魅力。如果你也想在本地部署 Deepseek,并深入体验其强大功能,这篇教程将为你提供详细的步骤指导。无论是 Windows 还是 Mac 平台,我将为你展示如何顺利部署并开始使用。

一、基础环境搭建

要在本地部署 Deepseek,首先需要安装 Ollama,这是 Deepseek 运行所依赖的环境。下面是安装和验证步骤:

1. 安装 Ollama

首先,访问 Ollama 官方网站下载页面:Ollama 下载。

根据你的操作系统选择合适的安装包(支持 Windows、Mac 和 Linux)。本文将以 Mac 和 Windows 为例进行说明。如果你无法安装,可以在我的公众号 nutpi 回复“Ollama”获取快速下载链接。

2. 安装过程

Mac 安装:

- 下载并打开

.dmg文件。 - 拖动 Ollama 应用到 Applications 文件夹。

- 等待安装完成后,打开 Ollama。

Windows 安装:

- 下载并运行

.exe文件。 - 按照安装向导完成安装。

3. 安装验证

安装完成后,需要验证 Ollama 是否成功安装。打开终端(macOS 用户可以使用终端,Windows 用户使用命令提示符),输入以下命令:

ollama -v如何打开终端:

- macOS:找到并打开“终端”应用(通常可以在“应用程序” > “实用工具”中找到)。

- Windows:按下

Win + R,输入cmd,然后按回车。

输入 ollama -v,如果返回类似以下结果,说明安装成功:

ollama version is 0.5.7二、模型部署

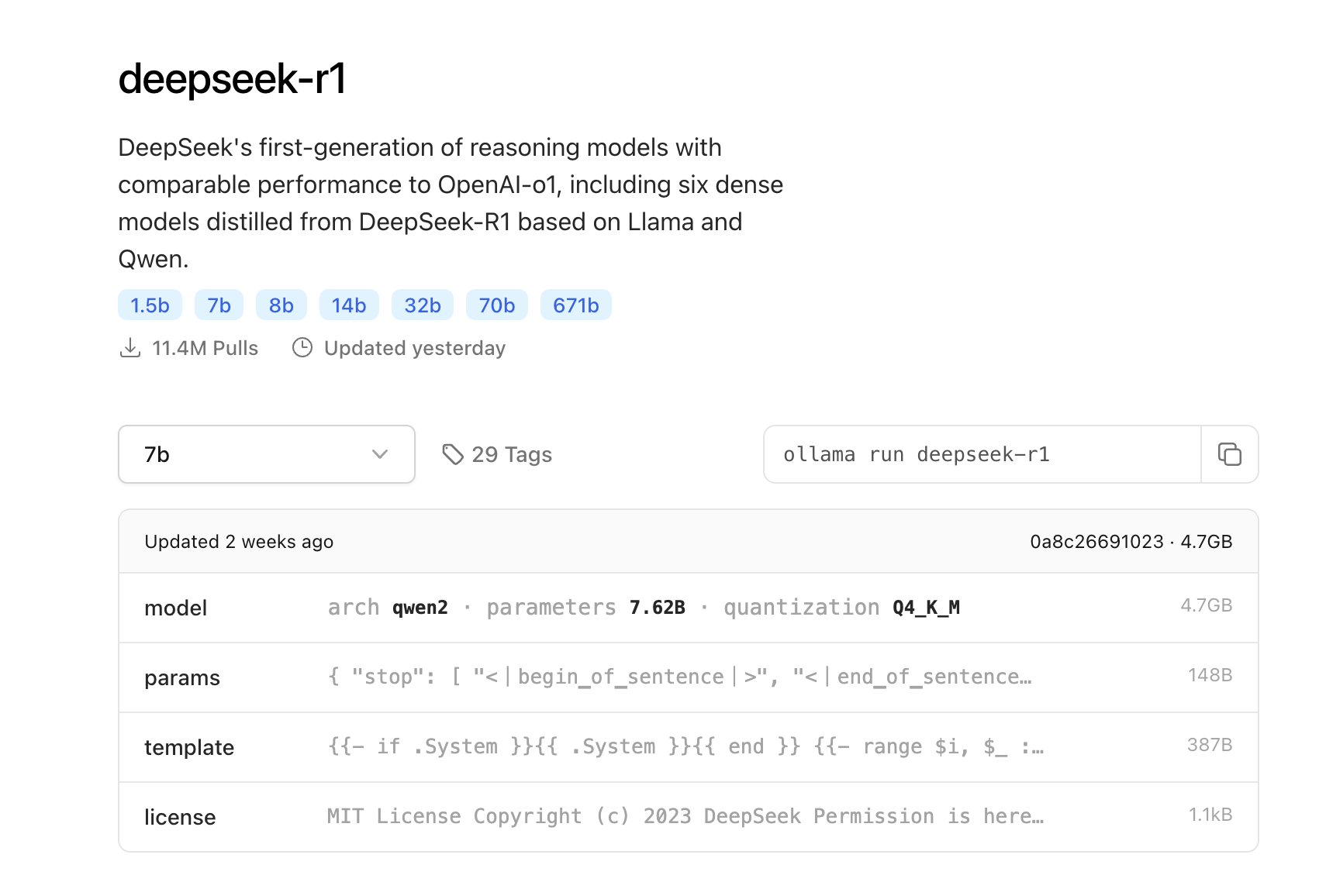

1. 下载DeepSeek模型:点击模型下载

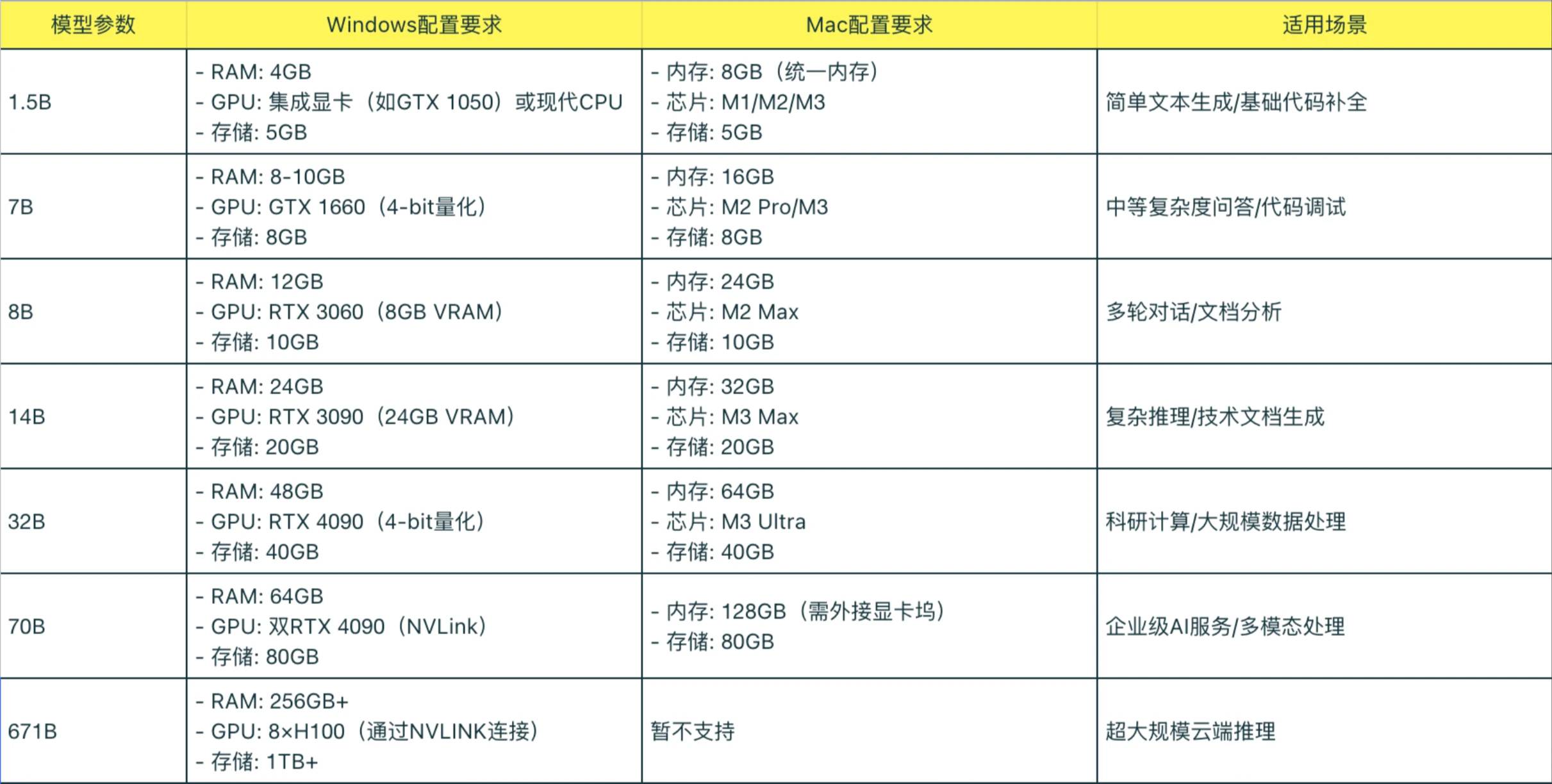

2. 选择版本

3. 运行安装命令

1.5B Qwen DeepSeek R1

ollama run deepseek-r1:1.5b7B Qwen DeepSeek R1

ollama run deepseek-r1:7b8B Llama DeepSeek R1

ollama run deepseek-r1:8b14B Qwen DeepSeek R1

ollama run deepseek-r1:14b32B Qwen DeepSeek R1

ollama run deepseek-r1:32b70B Llama DeepSeek R1

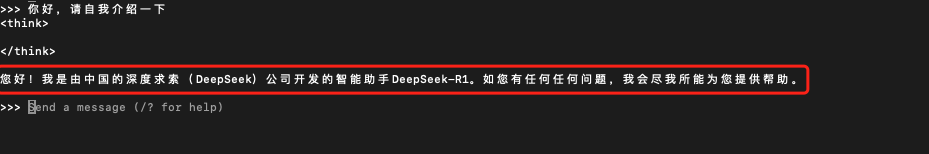

ollama run deepseek-r1:70b4. 出现如下界面安装成功

5. 模型测试

至此安装成功

三、安装可视化UI

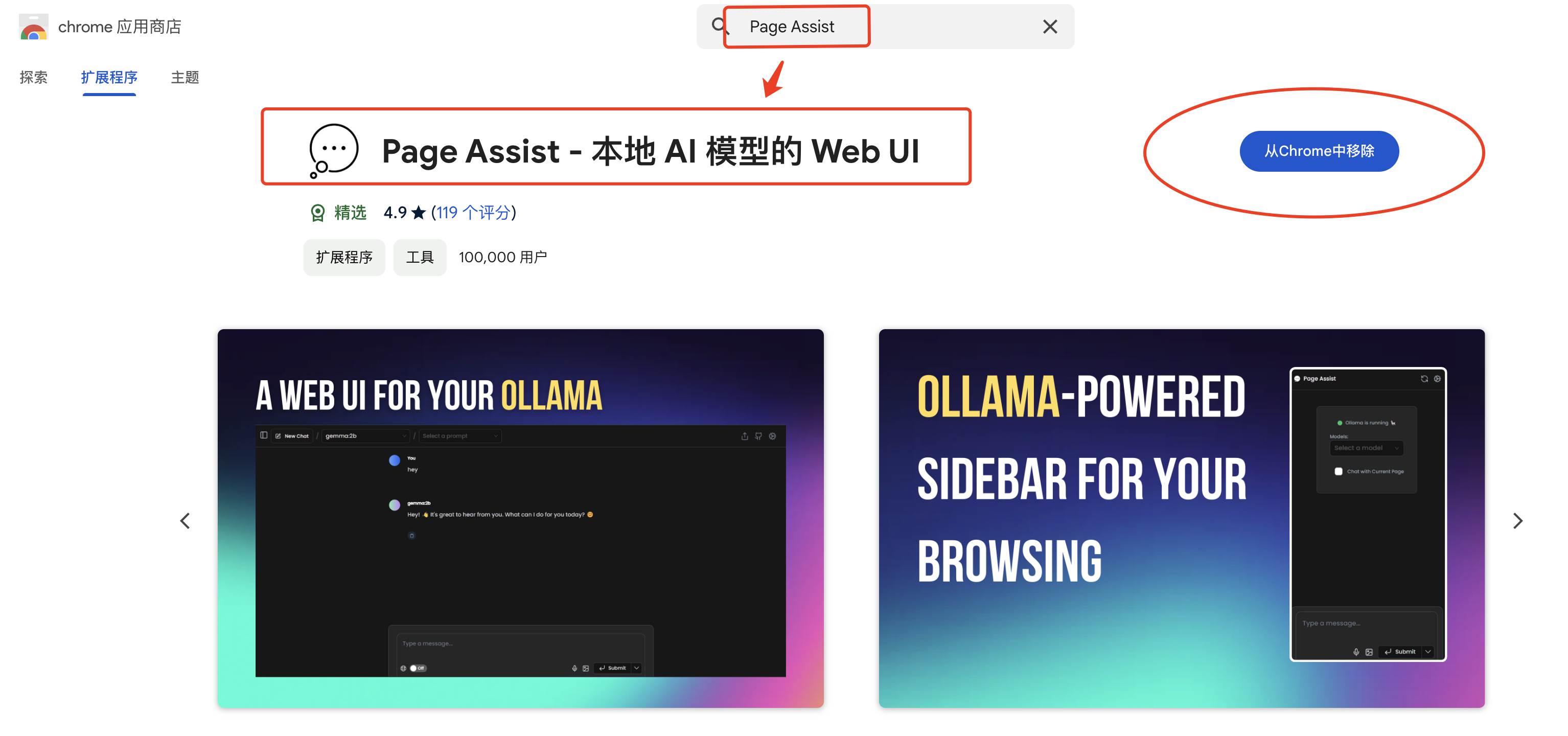

1. 安装插件

点击此链接安装:Page Assist – 本地 AI 模型的 Web UI

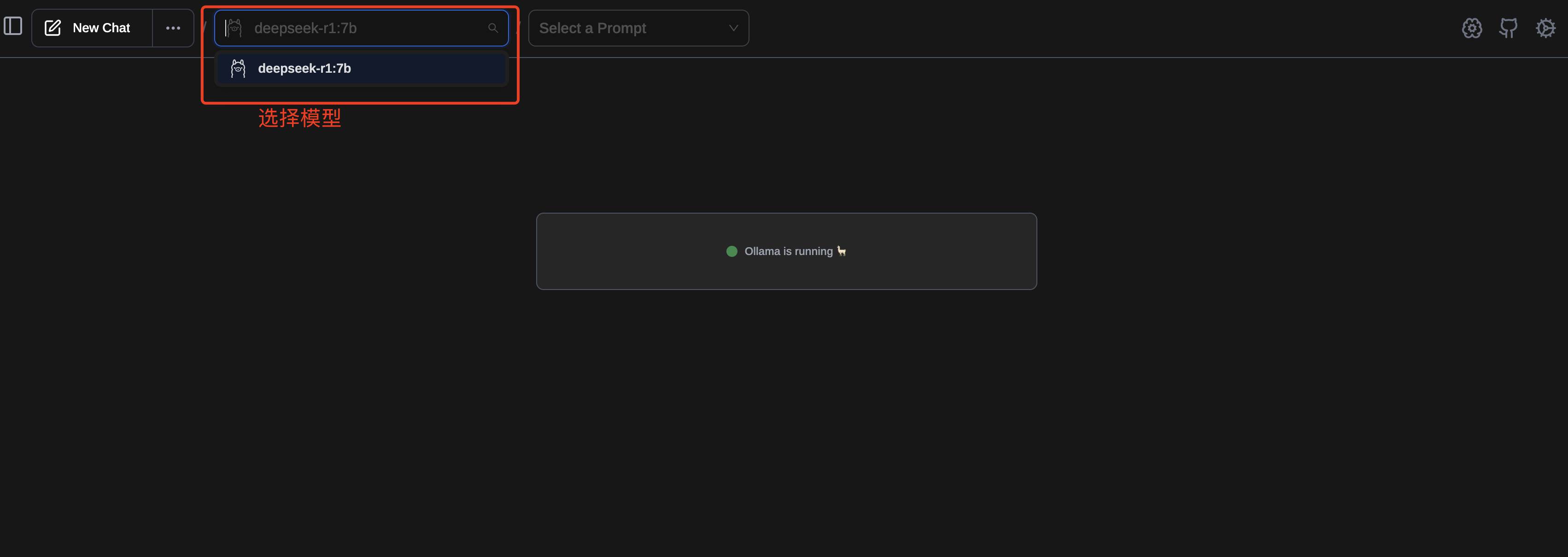

2. 选择模型

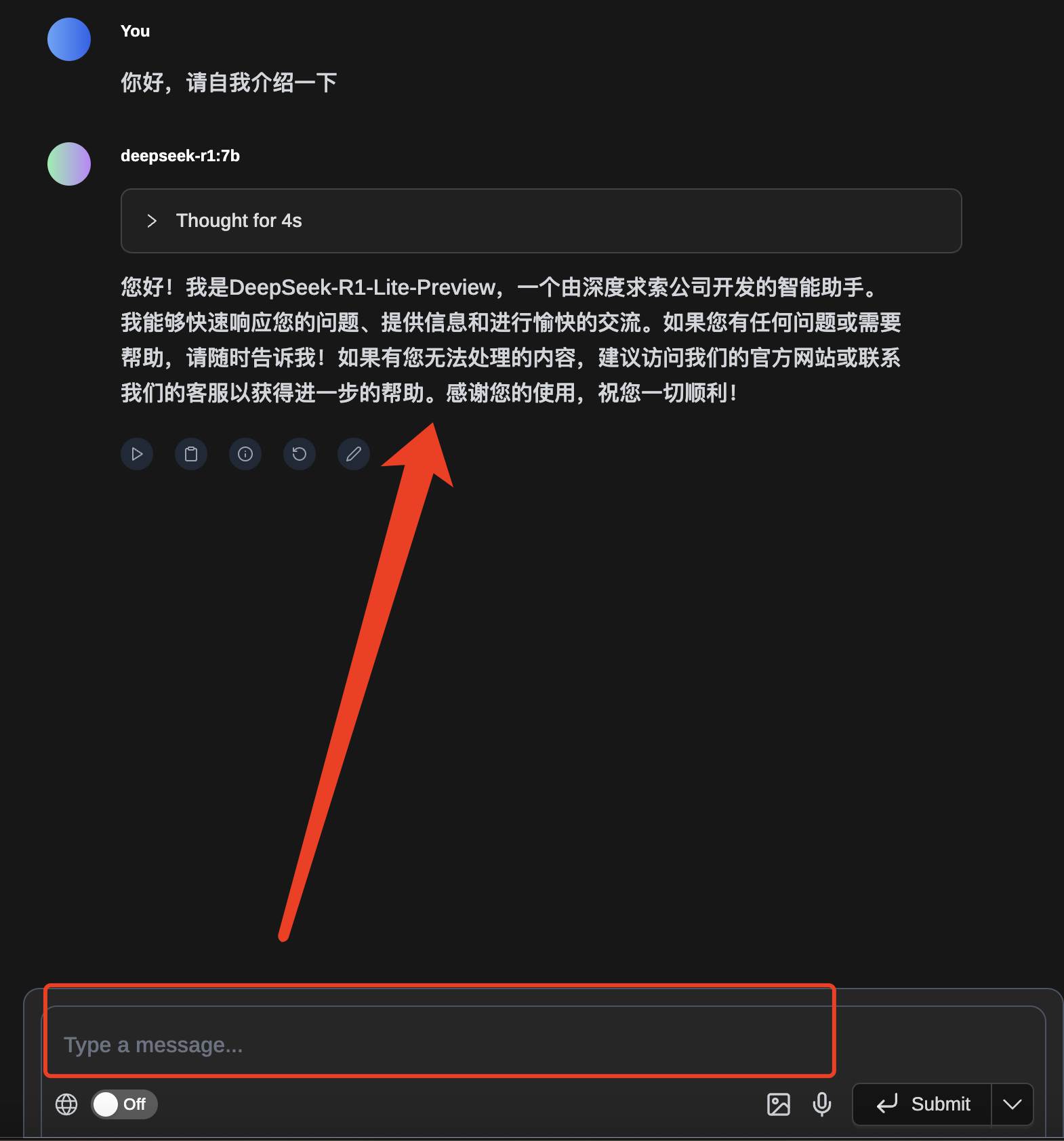

3. 测试插件

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

没有相关内容!

一次成功,Nice